Il problem solving (in italiano “il risolvere un problema”) è un’attività del pensiero che un organismo o un dispositivo di intelligenza artificiale mettono in atto per raggiungere una condizione desiderata a partire da una condizione data. Va precisato che il problem solving è solo una parte del processo di risoluzione di un problema: la procedura infatti comprende i processi seguenti: problem finding, problem shaping e problem solving.

Il problem solving (in italiano “il risolvere un problema”) è un’attività del pensiero che un organismo o un dispositivo di intelligenza artificiale mettono in atto per raggiungere una condizione desiderata a partire da una condizione data. Va precisato che il problem solving è solo una parte del processo di risoluzione di un problema: la procedura infatti comprende i processi seguenti: problem finding, problem shaping e problem solving.

Caratteristiche

Rispetto alla parola italiana “soluzione”, il termine inglese in “-ing” rafforza il significato di un atto in corso di svolgimento, come dire “risolvendo un problema“. Questo termine sta ad indicare la situazione psicologica nella quale si viene a trovare una persona quando, in conformità ad una varietà di dati e di richieste, deve affrontare e cercare di risolvere un problema. Fa inoltre riferimento a quell’insieme di ricerche e di teorizzazioni che sono state dedicate allo studio psicologico dei vissuti individuali, così come alle difficoltà che il soggetto incontra e agli elementi di facilitazione che egli introduce o possono essergli messi a disposizione. In un certo senso possiamo dire che il “problem solving” è un atto d’intelligenza, in quanto non consiste solo nel comprendere una spiegazione fornita da altri, ma comporta una partecipazione attiva e creativa, un qualche elemento di scoperta personale. L’espressione “problem solving” è stata originariamente utilizzata soprattutto in relazione ai problemi logico-matematici. Negli ultimi anni il termine si è esteso comprendendo lo studio delle abilità e dei processi implicati nell’affrontare i problemi di ogni genere. La visione secondo cui la vita dell’individuo si divide in una prima fase di apprendimento e in un secondo periodo di applicazione delle conoscenze acquisite, è da tempo superata. Oggi con l’espressione Life Long Learning ci si riferisce al processo di apprendimento che accompagna le persone lungo tutto l’arco della vita. L’aumento della complessità del contesto sociale, economico e tecnologico fanno sì che l’apprendimento permanente richieda lo sviluppo di competenze tra cui il problem solving, il pensiero critico, la creatività e la gestione costruttiva dei sentimenti. Tali competenze dette “trasversali” permettono di affrontare in modo razionale e costruttivo le più svariate difficoltà e di adattarsi ai vari cambiamenti contestuali. Secondo G.Polya, “Risolvere problemi significa trovare una strada per uscire da una difficoltà, una strada per aggirare un ostacolo, per raggiungere uno scopo che non sia immediatamente raggiungibile. Risolvere problemi è un’impresa specifica dell’intelligenza e l’intelligenza è il dono specifico del genere umano. Si può considerare il risolvere problemi come l’attività più caratteristica del genere umano.” Il problem solving diventa inoltre una competenza strategica nelle organizzazioni, in particolare nella leadership e nell’azione di comando e controllo, dove il criterio di base è la misura dell’efficacia e coerenza nel risolvere i problemi, criterio utilizzato per misurare i cambiamenti nel comportamento del sistema, le sue capacità, le variazioni dell’ambiente operativo che avvicinano l’organizzazione ai suoi “punti di arrivo” (“end-states”), e la creazione di effetti desiderati.

Leggi anche: Che cos’è l’intelligenza umana: definizione, significato e psicologia

Metodologie

Varie sono le tecniche e le modalità di problem solving che possono essere impiegate. Il problem solving prevede delle fasi che aiutano il soggetto ad impostare correttamente il problema e a chiarire alcuni aspetti che lo confondono, impedendogli di trovare delle soluzioni. Risolvere problemi è un lavoro che si affronta quotidianamente. A questo proposito sono stati pensati diversi metodi per aiutare le persone ad affrontare i problemi in modo articolato e soddisfacente. Il primo passo fondamentale per avviarsi verso la soluzione di un problema è il focalizzare l’attenzione sulla definizione e sui punti chiave del problema da risolvere. Una volta eseguito il primo passo si può procedere con le successive fasi di analisi. Se il vero problema non viene correttamente identificato si corre il rischio di lavorare alla soluzione di un falso problema risolvendo solo un falso fastidio che creerà la frustrazione di non essere stati capaci di sistemare la situazione problematica. Capire al volo se si è in una situazione a rischio richiede la sensibilità di:

- Identificare eventuali errori di definizione: succede spesso di giungere a conclusioni affrettate oppure di credere di aver capito il problema ma in realtà la situazione non è stata affatto chiarita. Questa è una situazione definita “jump to conclusion” ovvero saltare immediatamente alle conclusioni e alle soluzioni ritrovandosi così ad investire tempo e denaro nel fare attività che possono rivelarsi del tutto vane.

- Gli errori di linguaggio: l’abilità di identificare situazioni potenzialmente pericolose migliorerà di molto se particolarmente sensibili e suscettibili a tutti gli scenari in cui vi è un abuso delle parole errate di analisi della situazione presente. Esistono affermazioni che costituiscono un segnale che ci possono fare capire di essere in una situazione a rischio. Questo succede quando:

- si fanno delle accuse (si cerca quindi il colpevole invece di una soluzione);

- si è in presenza di una situazione poco chiara magari dovuta ad una scarsa leadership;

- si sta provando a fare un’azione che vale l’altra, cioè sembra che l’importante sia fare qualcosa.

- Fermare le lamentele: l’uomo trova spesso immediato conforto nel criticare ciò che è accaduto nel passato, ma alla lunga questo comportamento ha un effetto negativo in quanto contribuisce ad aumentare il senso di frustrazione ed impotenza di fronte ai problemi.

- Cambiamento di comportamento: fa riferimento all’attitudine dei leader di porsi come modello di riferimento nei confronti di coloro che non hanno ancora raggiunto lo stesso livello di preparazione.

- Scomporre il problema: molti tra i metodi di problem solving suggeriscono di suddividere il problema principale in problemi più piccoli per renderlo più gestibile.

Leggi anche: Quoziente d’intelligenza: valori, significato, test ed ereditarietà

APS (Applied Problem Solving)

APS, acronimo dall’inglese “Applied Problem Solving” e poi tradotto in italiano come “Applicare il Problem Solving” è un metodo di Problem Solving pratico, applicato a situazioni reali, in cui la semplicità e l’efficacia del metodo, unite alla forte enfasi sull’esecuzione delle soluzioni, vogliono essere il valore aggiunto rispetto ai metodi simili. La risoluzione dei problemi richiede la capacità di comprendere il contesto e l’ambiente, successivamente richiede che le persone vadano a raccogliere le evidenze in prima persona. Risolvere i problemi è un’attività faticosa in quanto si deve svolgere con la pratica, non solo con la teoria. È una metodologia che incorpora anche i processi cosiddetti di problem finding e problem shaping, mette assieme alcuni concetti già utilizzati da altri metodi e raggruppa in sé le fasi più efficaci e pratiche che permettono di:

- ricostruire gli accadimenti;

- definire il problema;

- capire dove effettuare le analisi;

- individuare le cause;

- investigare fino alla causa radice (Root Cause);

- studiare come applicare le soluzioni;

- decidere come monitorare le soluzioni;

- focalizzarsi per sostenere i risultati.

Il metodo è volutamente semplice perché vuole e deve essere applicabile a tutte le tipologie di problemi. Metodi più complessi possono essere più efficaci in singoli settori ma perdono drasticamente di efficacia se applicati in settori differenti.

DMAIC (Define, Measure, Analyze, Improve, Control)

La metodologia chiamata DMAIC (acronimo dall’inglese Define, Measure, Analyze, Improve, Control), fornisce alle organizzazioni un metodo strutturato per affrontare e risolvere i problemi. Originariamente il suo compito era quello di ridurre le variazioni soprattutto nei processi di produzione. In seguito il metodo è stato utilizzato per i compiti più generali come il miglioramento della qualità, il miglioramento dell’efficienza, la riduzione dei costi e di altre attività di gestione delle operazioni al di là della produzione, nel settore dei servizi, della sanità etc. Il DMAIC è un processo costituito da cinque fasi flessibili, ma molto efficaci, per ottenere miglioramenti e mantenerli attraverso tutta una serie di attività, dalla definizione del problema, all’attuazione di una soluzione. Gli obiettivi generali delle varie fasi sono:

- DEFINE: in questa fase vengono definiti i processi che presentano delle criticità per l’azienda. Le criticità possono riguardare ambiti relativi al prodotto, al servizio o appartenere ad aree transazionali. La fase di define si concentra sulla ricerca delle criticità più importanti all’interno di una azienda; queste sono le caratteristiche “critiche per la qualità” (CTQ). La sua finalità è quella di istituire un “monitoraggio” sia economico sia basato sulla soddisfazione del cliente per stabilire quale debba essere l’obiettivo dei progetti Sei Sigma da iniziare. Stabilito l’obiettivo, la fase di define serve a chiarire in linea generale quelle che sono le aspettative (e quindi il risultato previsto) e quelle che sono le risorse necessarie (sia in termini di risorse umane che strutturali e temporali) per portare a termine il progetto. In questo senso la fase di define si concentra anche sulla realizzazione di una prima mappa di processo che mostri tutte le fasi e le figure coinvolte.

- MEASURE: nella fase di measure viene misurata, cioè valutata tramite delle misurazioni, l’efficacia dei processi. “Valutare” se un processo è efficace, cioè realizza effettivamente gli obiettivi per cui è stato ideato. Un’azienda che non è capace di esprimere sotto forma di misure le prestazioni di un processo, non comprende pienamente quel processo e i risultati ottenibili attraverso esso. La vera importanza del singolo processo si comprende inquadrando ogni operazione all’interno dell’iter lavorativo; processi “deboli” generano problemi di qualità; questi a loro volta influiscono sui tempi di realizzazione del lavoro. Per valutare in modo rigoroso l’efficacia dei processi, è quindi necessario: suddividere i processi nelle singole operazioni che li costituiscono; definire e mappare i processi correlati; scoprire gli anelli deboli dei processi. La fase di measure si concentra infatti sulla realizzazione di un piano di raccolta dati robusto che permetta di valutare quali siano le informazioni necessarie da raccogliere e quali le modalità di raccolta dati. I dati collezionati nella fase di measure sono la base della strategia Sei Sigma e sono indispensabili per proseguire nelle fasi successive della metodologia. Sono i dati infatti che evidenziano i legami tra le informazioni raccolte per definire il problema alla base del progetto e le possibili soluzioni e decisioni che saranno prese per ottimizzare il processo studiato.

- ANALYZE: nella fase di analyze vengono analizzati i dati raccolti nella fase di measure al fine di determinare le relazioni tra i fattori variabili del processo per valutare quali siano i fattori sui quali sia possibile agire per spingere il miglioramento del processo. L’analisi dei dati rivela infatti l’influenza delle singole variabili (se è presente o meno e come è possibile quantificarla) sull’output del processo. Si cerca in particolare la correlazione tra cause (parametri del processo) ed effetti (criticità del processo). L’analisi dettagliata del processo permette anche di mettere in evidenza i limiti tecnologici intrinseci nel processo allo studio, al fine di individuare la tipologia di azioni di miglioramento necessarie.

- IMPROVE: Nella fase di improve viene ricercata una soluzione migliorativa ai problemi riscontrati in fase di analisi, in modo da ottimizzare il processo studiato. Nel momento infatti in cui si ipotizza che migliorare un prodotto significa migliorare il processo alla base della sua realizzazione, sorge un interrogativo: ” Come è possibile identificare, definire, ottimizzare e controllare i fattori chiave del processo?”. Al fine di rispondere a questo quesito, l’attenzione deve essere rivolta alle caratteristiche CTQ, identificate già nella fase di define e verificate mediante l’analisi dei dati. Migliorare le caratteristiche chiave del processo significa innanzitutto individuare le variabili che hanno un forte impatto sulle prestazioni del processo stesso ed orientarle verso un aumento della loro efficacia. A tale fine vengono stabiliti dei limiti in cui devono essere contenute le variabili.

- CONTROL: Una volta che il processo è stato ottimizzato, è necessario implementare un sistema di controllo che permetta di mantenere il livello di qualità raggiunto anche nel tempo. I processi lasciati “a se stessi” tendono infatti a degradare le proprie prestazioni a causa dell’intervento di cause speciali, tali da influenzare in modo anche considerevole le caratteristiche del processo. Queste derive possono essere evitate utilizzando strumenti di monitoraggio che, in modo preventivo, mettano in mostra le cause speciali in atto prima che queste portino ad un degrado del processo. Inoltre, attraverso la fase di control ci si assicura che i problemi che si sono verificati in passato non si ripresentino.

Leggi anche: Com’è fatto il cervello, a che serve e come funziona la memoria?

FARE

La metodologia chiamata FARE consta di quattro fasi, che creano l’acronimo: Focalizzare, Analizzare, Risolvere ed Eseguire.

Focalizzare (definire i dettagli del problema):

- selezionare il problema;

- verificare e definire il problema;

- fare una descrizione scritta del problema.

Analizzare (definire gli elementi critici e rilevanti):

- decidere cosa è necessario sapere;

- raccogliere i dati di riferimento;

- determinare i fattori rilevanti, i valori di riferimento ed i fattori critici.

Risolvere (elencare soluzioni possibili):

- generare soluzioni alternative;

- scegliere la soluzione del problema;

- selezionare una soluzione.

Eseguire (realizzare il piano di attuazione e valutare i risultati):

- eseguire la soluzione scelta;

- completare il piano di attuazione;

- eseguire la valutazione finale.

Leggi anche: Effetto alone e bias cognitivo in psicologia, economia, marketing

FMECA

Lo FMECA (acronimo da Failure modes, Effects, Criticality Analysis) è l’evoluzione naturale della metodologia FMEA introdotta alla NASA a partire dal 1950, nell’ambito del programma lunare Apollo. È una metodologia di studio affidabilistico che fu pensata originariamente a supporto della progettazione di prodotti/sistemi complessi. Negli anni più recenti ha però trovato ampio spazio di applicazione in altri ambiti di utilizzo, quali l’analisi di processo e la manutenzione industriale. Per quanto riguarda l’applicazione della metodologia FMECA nella manutenzione industriale, essa si è affermata come lo strumento d’elezione per:

- l’analisi delle modalità di guasto di un’entità complessa;

- l’identificazione dei suoi elementi critici dal punto di vista affidabilistico;

- la definizione ragionata del piano di manutenzione a partire dai componenti critici.

La FMECA è una metodologia che si è consolidata sia per effetto della presenza di numerosi standard internazionali, che per la sua adozione, secondo diverse interpretazioni, nella pratica industriale. Sostanzialmente la metodologia FMECA è costituita da una procedura per l’analisi di un’entità complessa (macchina, impianto, sistema di qualsivoglia natura) fondata su due principi fondamentali. Il primo è costituito dalla scomposizione gerarchica dell’entità sotto esame in sottogruppi a complessità decrescente, fino ad arrivare al livello di dettaglio voluto (eventualmente fino ai componenti elementari). Il secondo principio consiste nell’esecuzione dell’analisi di affidabilità ad ogni livello e cioè nella determinazione di modo, causa, meccanismo ed effetto del guasto a quel livello, valutando in modo opportuno le criticità dell’entità in esame. Alla fine di questo processo di analisi si ottiene un quadro estremamente articolato e documentato del modo e della probabilità con cui si possono generare i guasti nell’entità e, su tale base, si possono definire le più opportune azioni di progettazione, pianificazione e miglioramento della manutenzione o del progetto dell’entità.

Leggi anche: Gli integratori per allenare il tuo cervello e sviluppare una memoria prodigiosa

PDCA

La metodologia del PDCA, nota anche come ciclo di Deming, è la rappresentazione visiva di un circolo definito “virtuoso” e di miglioramento continuo per prodotti, processi e problemi specifici. PDCA è l’acronimo dell’inglese Plan, Do, Check, Act (“pianifica, prova, verifica, agisci”).

- Plan (pianifica): è necessario iniziare con la progettazione degli obiettivi e dei compiti, analizzare la situazione in cui ci si trova e ricercare le cause che hanno generato le criticità. In seguito a questo è necessario definire le possibili azioni correttive e risolutive della situazione.

- Do (prova): in seguito alla progettazione si procede con la realizzazione concreta, pertanto le azioni pensate vengono tradotte in pratica. Nel concreto si comincia ad attivare degli interventi anche su piccola scala in modo da risolvere la situazione problematica.

- Check (verifica): si analizzano le conseguenze delle azioni intraprese si verifica se tali risultati combaciano con gli obiettivi che erano stati definiti nella fase iniziale. Se tutto va bene si passa all’ultima fase altrimenti si apportano ulteriori modifiche correttive, fino a quando funziona tutto bene.

- Act (agisci): se tutto funziona come desiderato, si rende stabile il cambiamento e lo si inserisce in produzione. In questo caso non è più una prova come nella fase “Do” ma si è pienamente convinti di quello che si sta mettendo in atto al fine di creare cambiamento.

La ruota di Deming si applica a qualsiasi campo e a qualsiasi livello. Alla fine del ciclo, quando il cambiamento è entrato nella normalità, si è pronti per avviare un nuovo ciclo, realizzando così un processo di miglioramento continuo.

Leggi anche: Più il nostro quoziente intellettivo è alto e meno crediamo in Dio: gli atei sono più intelligenti dei credenti

Risolvi ed analizza

Questa metodologia viene utilizzata in ambito informatico per circoscrivere i problemi e costruire delle metodologie specifiche per gli utenti che si basano sull’esperienza comune e sulla condivisione delle conoscenze. Per risolvere un problema in modo definitivo ed efficace non basta più conoscere a fondo uno specifico aspetto dell’impresa. Problemi complessi e globali richiedono nuove competenze di problem solving: il Systems Engineering, applicato da migliaia di imprese di tutte le dimensioni e di tutti i settori, è un metodo che si fonda sull’applicazione pratica del pensiero sistemico (system thinking), che permette di descrivere e analizzare un problema in un’ottica globale.

I principi fondamentali sono 3:

- Cercare la responsabilità di una situazione problematica rallenta la soluzione dello stesso senza portare benefici evidenti;

- Se si trova una soluzione bisogna rendere disponibile una descrizione dettagliata del problema e del metodo per risolverlo;

- Se non si trova una soluzione è comunque importante dettagliare bene il problema e descrivere accuratamente i passi da seguire affinché il problema non si ripresenti.

Le operazioni da seguire sono le seguenti:

- relazionare gli effetti del problema;

- relazionare la situazione hardware e software;

- identificare tutte le modifiche effettuate prima dell’esistenza del problema;

- ricercare ed analizzare le cause;

- porre rimedio se possibile;

- verificare che il rimedio abbia risolto effettivamente il problema;

- relazionare la soluzione oppure dichiarare l’impossibilità di trovare una soluzione adeguata.

Strumenti

Quelli che seguono sono strumenti diffusi e comunemente utilizzati dai metodi di problem solving per svolgere con successo alcune fasi particolari del metodo di lavoro. Gli strumenti di gestione per il problem solving sono definiti come un insieme di procedimenti mentali, ossia tecniche di pensiero atte a far emergere dei risultati utili ai fini della soluzione del problema che attingono dal contributo di molteplici discipline come l’economia, la psicologia, la matematica e la sociologia.

5W2H

La 5W2H è un’analisi semplificata delle cause tecniche. Le 5W sono rappresentante dalle cinque domande:

- Who (“Chi?”);

- What (“Cosa?”);

- Where (“Dove?”);

- When (“Quando?”);

- Why (“Perché?”).

Le 2H rappresentano le due domande:

- How (“In che modo?”);

- How many (“Quanti?”).

Rispondendo a queste sette domande totali, si possono individuare alcune delle principali cause del problema. Questa tecnica può essere utilizzata per aiutare a definire un reclamo del cliente o la ritardata consegna di un fornitore o in ogni altra situazione che si può incontrare nella filiera di produzione. Con una definizione specifica del problema si può iniziare un lungo cammino verso lo sviluppo di una vera e propria soluzione.

Leggi anche: I 21 segni che indicano che sei intelligente

Analisi di Ishikawa

Viene anche chiamato diagramma causa-effetto, diagramma a lisca di pesce o diagramma ad albero. Il diagramma di Ishikawa prende il nome da Kaoru Ishikawa, che lo inventò e mise a punto nel 1969 ed è uno strumento che permette e facilita l’analisi di un certo fenomeno o problema da parte di un gruppo di persone grazie alla sua stessa struttura. Esso è inteso nei termini di una rappresentazione logica e sistematica delle relazioni esistenti tra un problema e le possibili cause che l’hanno generato.

Per procedere all’applicazione di questo strumento bisognerà innanzitutto che il gruppo che analizzerà il fenomeno sia un team costituito da persone che possiedono esperienza in merito al tema alla base del problema ed in secondo luogo bisognerà avvalersi dello strumento di brainstorming mediante cui i componenti esprimeranno liberamente le personali posizioni in merito alle possibili cause del problema. A questo punto si dà il via alla costruzione del diagramma che riporta alla destra, (in un’ideale testa della lisca di pesce) il problema così come lo si è denominato e a partire da questa “testa” si articolano via via le cause emerse che si organizzano in diversi rami secondo un ordine gerarchico: dalle cause che hanno generato il problema si articolano rami secondari che presentano le cause che a loro volta hanno incrementato o generato le cause principali del problema individuate.

Il momento della costruzione ed applicazione dello strumento si compone delle seguenti fasi:

- si individua innanzitutto l’effetto o problema da analizzare;

- si rappresenta il fenomeno mediante la costruzione del diagramma causa-effetto;

- si analizzano le correlazioni di causa-effetto emerse dal diagramma;

- si focalizza l’attenzione sulle possibili cause, dunque si procede ad un’indagine sulle probabili cause prese una per volta;

- si individua l’azione correttiva ritenuta più opportuna;

- si verifica l’efficacia effettiva dell’azione di correzione individuata.

Una volta strutturato il diagramma vanno analizzate dal gruppo le cause individuate. Per prima cosa si devono individuare le cause più probabili, successivamente si rilevano le cause più importanti, ed infine si verifica se le cause individuate come più importanti siano o meno quelle che influenzano realmente il problema, se siano cioè le vere cause. La tappa che consiste nella verifica delle cause individuate si compone delle seguenti azioni:

- si prende in esame la prima causa e si progettano le possibili verifiche utili per validare o smentire l’ipotesi fatta;

- nel caso in cui il problema permanga ugualmente l’ipotesi formulata non è corretta;

- si procede con le altre cause nella medesima maniera, verificando dunque se l’ipotesi sulle successive cause sia corretta o gli effetti permangano;

- nel caso in cui non si individui ancora la soluzione al problema, nonostante la corretta applicazione dei punti precedenti, si procede con il riesaminare nuovamente tutta l’analisi;

- infine è necessario rimuovere ogni causa individuata anche quando la causa principale è stata individuata.

Suggerimenti per l’applicazione di questo strumento: nella costruzione del diagramma si usufruisca della collaborazione di molte persone, si incoraggino tutti gli interventi e tutti i commenti nella fase di brainstorming senza considerarne alcuno futile o bizzarro, tenendo in considerazione che più cause emergono, meglio è. Delle indicazioni finali importanti riguardano poi la considerazione di errori di campionamento, errori di ispezione ed errori dovuti a disattenzione, che sono importanti allo scopo di evitare errori nell’analisi dell’effetto o problema e il procedere con calma, senza nessuna urgenza nel trovare delle soluzioni concrete.

Leggi anche: Analfabetismo funzionale: significato e differenze con l’analfabetismo “classico”

Brainstorming

Il brainstorm o brainstorming (“tempesta di cervello”) è una tecnica impiegata per facilitare la soluzione di un problema e stimolare il pensiero creativo; tende a liberare l’immaginazione delle persone, il cui cervello, come suggerisce il nome, è effettivamente messo in continua agitazione. Consiste in una riunione, che può coinvolgere da pochi allievi a un gruppo anche di cinquanta persone, in cui la ricerca della soluzione di un dato problema avviene mediante la libera espressione delle idee e delle proposte che il tema stesso avrà stimolato in ognuna delle persone coinvolte.

Il brainstorming, diffuso per la prima volta da Osborn nel 1957, si fonda sul principio essenziale del debridage (“sbrigliamento”), per cui nessuna idea, nessuna proposta, può essere respinta o rifiutata. Ciascuno ha diritto di dire ciò che pensa utilizzando la forma che preferisce. Tende dunque ad abolire i comportamenti e gli atteggiamenti critici verso le idee espresse, in quanto, come afferma Rogers, costituiscono la barriera più forte per la comunicazione. Infatti, se il membro di un gruppo teme di essere giudicato, tenderà a non esprimersi liberamente e le sue potenzialità ideative verranno inibite. Il senso di appartenenza al gruppo contribuisce ad aumentare il livello di sicurezza individuale: ogni membro si sente più protetto e difeso dall’atmosfera critica e giudicante del rapporto interumano. Ne consegue anche la diminuzione del senso di colpa che ogni decisione e ogni comunicazione comportano (date le modifiche che l’individuo provoca in sé e negli altri quando esprime un proprio messaggio). Viene dunque rinforzata la personalità del soggetto, si incrementano la sua creatività e la possibilità di comunicazione della creatività stessa. Il brainstorming trova ulteriore fondamento nella teoria psicologica dell’associazione di idee. Questa teoria afferma che ogni partecipante si lasci andare alle proprie associazioni libere, senza censura, accogliendo le produzioni altrettanto spontanee degli altri membri del gruppo come un bene comune, su cui può continuare ad associare: molto spesso, infatti, un’idea ne genera un’altra, questa ne ispira un’altra ancora e così via, in una reazione a catena. Si passano così in rassegna tutte le possibili interpretazioni di un fenomeno, mettendo su un piano di pari valore le soluzioni più sagge e le spiegazioni più inconsuete.

Alla fine il risultato che si ottiene è ricco, inatteso e lascia intravedere prospettive promettenti. Il brainstorming costituisce un notevole strumento di allenamento, di formazione e di insegnamento, grazie al quale i partecipanti acquisiscono progressivamente:

- fiducia nella propria personale capacità di immaginazione, stimolata dalle interazioni e protetta dalla critica altrui;

- spontaneità, che fiorisce nell’improvvisazione e nell’illuminazione provocata da un’idea appena formulata;

- fiducia negli altri, le cui proposte possono ispirare e aiutare il precisarsi delle proprie: anche le idee apparentemente assurde e banali si dimostrano un anello indispensabile della catena di associazioni e per tale motivo è essenziale che tutti esprimano le loro idee.

La tecnica aiuta anche a sviluppare un atteggiamento elastico, interrogativo, di apertura permanente nei confronti di un problema.

Leggi anche: Fallacie logiche nella retorica ed in politica: caratteristiche, tipi esempi

Regie di cambiamento

Il metodo delle regie di cambiamento si colloca tra le attività che inquadrano il problem solving tra le competenze essenziali da fornire nella formazione aziendale, facendole divenire competenze allenabili, tra cui l’autore del modello individua:

- Problem Sensing: capacità di percepire che in una situazione esistono problemi, riconoscere una situazione come problematica; capacità di intuire problemi utilizzando segnali deboli.

- Problem Finding: ricerca attiva di possibili problemi, rilevare, scoprire problemi, andare a caccia di problemi; non limitarsi a lavorare su problemi “ricevuti”, ma andare a stanarli attivamente.

- Problem Mapping: costruire mappature di problemi (es.: posizionarli su un diagramma per grado di frequenza e grado di pericolosità); differenziarli, definire priorità, valutare i “cluster” di problemi (aggregazioni).

- Problem Shaping: dare forma al problema, individuarne i tratti principali; capire i confini del problema, cosa vi rientra e cosa non vi rientra.

- Problem Setting: la capacità di fissare il problema in termini di variabili e loro rapporti, di dare una definizione chiara del problema, e suoi confini; capacità di darne definizioni trasmissibili, comunicabili, chiare.

- Problem Talking: la capacità di parlare del problema saper spiegare ad altri la propria visione lucidamente, fare una buona comunicazione nel team e verso l’esterno; utilizzare stili comunicativi efficaci.

- Problem Analysis: svolgere analisi scientifica (qualitativa e quantitativa) in grado di aumentare la nostra comprensione del problema, delle sue strutture, dei rapporti di causa ed effetto.

- Problem Refraiming: osservare il problema attraverso un frame diverso (es.: psicologico vs. tecnologico); riformulare il problema da altre angolature, percepirlo da punti di vista completamente diversi, cambiare il paradigma di riferimento.

Leggi anche: Sindrome dell’idiota sapiente: cause, caratteristiche e sintomi

Fault Tree Analysis

L’albero dei guasti, noto generalmente come Fault Tree Analysis, è una metodologia di analisi del rischio che tramite visualizzazione grafica consente di individuare le cause iniziatrici di incidenti che sono frutto di una complessa combinazione di eventi. Il risultato dell’analisi è un diagramma logico, mutuato dalla teoria delle decisioni che, in definitiva, risponde a questa domanda: “Che cosa deve succedere perché si abbia un determinato guasto?”. È una tecnica induttiva che parte dagli eventi finali, detti Eventi Top o Eventi Critici, (scoppio, incendio, rilascio di materiale tossico, contaminazione al di fuori dei limiti, etc.) e risale ai guasti od agli errori iniziali (Fault). Un albero dei guasti è un diagramma costruito con l’utilizzo di porte logiche and/or che illustra le relazioni tra le cause iniziatrici e l’evento finale indesiderato mostrando al contempo il contributo di ogni fattore.

Problem solving in psicologia

Lo studio della soluzione di problemi è un campo di ricerca originariamente creato dalla psicologia del pensiero, una branca della psicologia sperimentale che si occupa dello studio fenomenologico delle diverse modalità ideative (immaginazione, ragionamento), al fine di isolare i fattori psicologici che le determinano. In senso stretto la psicologia del pensiero si è però rivolta allo studio di problematiche specifiche quali la formazione dei concetti, la genesi e lo sviluppo del pensiero logico e la risoluzione di problemi. Secondo il Kanizsa “Un problema sorge quando un essere vivente, motivato a raggiungere una meta, non può farlo in forma automatica o meccanica, cioè mediante un’attività istintiva o attraverso un comportamento appreso”.

Per poter sostenere l’esistenza di un problema si devono verificare due condizioni: la presenza di una motivazione che spinge a perseguire un fine e l’indisponibilità della strategia necessaria per raggiungerlo. La motivazione, vale a dire la spinta ad agire, può consistere in un bisogno fisiologico o in bisogni propri del soggetto (come la curiosità); di conseguenza il problema susciterà degli interrogativi, delle domande configurandosi come una “situazione problematica”. Afferma ancora il Kanizsa che “Si è sempre assunta l’esistenza del problema come un dato, come un fatto esistente per sé e non richiedente ulteriore comprensione.

Ma questa assunzione del problema come dato dal quale partire è arbitraria: il problema non è un dato, un fatto naturale, ma è un prodotto psicologico. Si converrà senza difficoltà che esiste un problema solo là e quando vi è una mente che vive una certa situazione come problema. Diciamo di più, e più esattamente: vi è problema solo quando la mente crea o determina il problema: vi è problema solo nella dimensione psicologica, non in quella naturale, od oggettiva”.

Leggi anche: Effetto von Restorff: cos’è e come usarlo a tuo vantaggio

Psicologia della Gestalt

Lo studio su come si svolgono i processi di pensiero di fronte ad una situazione problematica, è stato profondamente influenzato dalle concezioni teoriche e dalle analisi sperimentali degli psicologi di orientamento gestaltista, in particolare di Wertheimer, Köhler, Koffka e Duncker. Il termine “problem solving” si incontra di rado negli scritti degli psicologi gestaltisti che preferiscono parlare di pensiero produttivo. Questa preferenza mette in risalto la convinzione che l’attività non si riduca ad una mera riproduzione del passato, al riemergere di idee, di immagini, di comportamenti che sono già esistiti, ma che, accanto a quell’attività riproduttiva, ci siano anche processi che producono veramente il nuovo, che creano ciò che non è ancora stato, che fanno scaturire l’idea mai sorta prima, almeno nella mente di quel determinato organismo pensante.

Le prime ricerche condotte in riferimento a quest’indirizzo furono quelle di Köhler, il quale studiò, tra il 1914 e il 1917, il comportamento di animali (e in particolare di scimpanzé) posti in situazioni problematiche molto semplici (ad esempio uno scimpanzé doveva trovare il modo di impossessarsi di una banana appesa al soffitto di una gabbia o collocata all’esterno di questa ad una certa distanza dalle sbarre, avendo a disposizione alcuni oggetti che avrebbero potuto utilizzare come strumenti: un bastone, una cassa, una scala portatile, ecc.). Köhler ha così potuto stabilire che questi animali sono capaci di ristrutturazioni improvvise dell’ambiente, che costituiscono una soluzione del problema (ad es. portando la cassa, sino a poco prima usata solo come recipiente o sedile, sotto la banana e utilizzandola come mezzo per alzare il livello del pavimento). Egli osservò che dal comportamento concreto dell’animale e dalla sua ristrutturazione oggettiva di tale ambiente era possibile risalire ai processi di ristrutturazione che potevano avere avuto luogo nella sua rappresentazione cognitiva dell’ambiente.

Köhler suppose che il pensiero ed il problem solving non erano la semplice somma di stimolo-risposta, ma che doveva in qualche modo avvenire una percezione globale del problema come totalità funzionale. Il problema, cioè, diventava comprensibile e risolvibile proprio perché i rapporti tra gli elementi in gioco improvvisamente si mostravano agli occhi dell’individuo in tutta la loro evidente chiarezza. Questo fenomeno, vitale per l’evoluzione del processo di pensiero, fu indicato dai gestaltisti con il termine di Einsicht o, in inglese, insight che letteralmente significa “vedere dentro”, cioè intuire. Fu però il lavoro di M. Wertheimer a chiarire il significato di “struttura” e di “insight” nell’ambito più specifico dell’insegnamento. Il pensiero che comprende una struttura venne da lui ribattezzato “pensiero produttivo”, cioè quel tipo di pensiero che, partendo da un problema, produce una struttura nuova avente carattere di soluzione. Il lavoro di Wertheimer ha per oggetto il pensiero umano e si svolge attraverso un’analisi minuziosa ed affascinante del modo in cui concretamente una persona affronta un problema, si affatica intorno ad esso ed infine lo risolve.

Secondo Wertheimer è necessario osservare la situazione liberamente, a mente aperta, con una visione complessiva, cercando di capire fino in fondo, di rendersi conto, di mettere in evidenza la relazione interna che esiste tra la forma e il compito assegnato giungendo, nei casi migliori, alle radici della situazione, illuminando e rendendo trasparenti i caratteri di struttura essenziali. Dagli studi di Wertheimer prendono spunto quelli del suo allievo K. Duncker. Egli ha studiato a fondo le situazioni in cui l’insight non ha luogo d’un tratto, ma solo al termine di un lungo processo di ricerca nel corso del quale la prima fase è costituita da una soluzione del problema di partenza che però si rivela subito come troppo generica, permettendo solo di riformulare tale problema in termini più definiti, dando così avvio ad una seconda fase e poi ad altre, ciascuna delle quali rappresenta una soluzione rispetto al problema immediatamente precedente ma apre a sua volta un problema più specifico. Egli si è anche occupato delle strategie con cui può essere affrontato il problema distinguendo fra le “analisi dall’alto” (quelle cioè che prendono come punto di partenza l’obiettivo, e le richieste che esso pone), e le “analisi dal basso” (quelle cioè che prendono avvio da una considerazione del materiale a disposizione, e delle possibilità che esso offre, in vista di un certo obiettivo). Un punto di grande interesse sia psicologico che pedagogico è quello delle difficoltà che il pensiero può incontrare nella ricerca di una soluzione.

Duncker ha messo in evidenza una difficoltà, di carattere generale, consistente nel fenomeno della fissità funzionale, ovvero nella tendenza ad utilizzare certi oggetti solo per quelle che sono le loro funzioni abituali (per es. un paio di forbici per tagliare) senza giungere a vedere che in certe situazioni essi potrebbero essere utilizzati per funzioni diverse e insolite (ad es. le forbici come compasso). Un’altra difficoltà, che si presenta quando un problema è formulato verbalmente, consiste nelle cosiddette implicazioni parassite dei termini verbali ovvero in interpretazioni riduttive del significato di certe parole le quali limitano indebitamente le direzioni lungo le quali viene cercata una soluzione. Fra le strategie che hanno un valore euristico, possono cioè rendere più facile la scoperta di una soluzione, un ruolo notevole può avere quella della semplificazione, consistente nel cambiare i dati di un problema sostituendoli con altri assai più semplici, senza tuttavia modificare la struttura del problema stesso, che è però in tal modo assai più evidente, rendendo più agevole la ristrutturazione. Una notevole utilità possono avere le rassegne di situazioni analoghe già vissute, che, come osserva Duncker, possono suggerire, “per assonanza”, delle proposte di soluzione e le esperienze di brainstorming, compiute sia in gruppo che individualmente, sulla base del principio che una certa idea può favorire l’emergere di altre (per contrasto, per completamento, per differenziazione).

Se vuoi potenziare le tue capacità di problem solving, prenota il tuo colloquio riservato e ti aiuterò a migliorare le tue abilità e ad esprimere al meglio tutte le tue potenzialità.

Leggi anche:

- Euristiche e bias cognitivi: i 16 modi con cui il tuo cervello ti porta a sbagliare

- Sillogismo: spiegazione, tipi, esempi, etimologia

- Fallacia dello scommettitore o del giocatore d’azzardo

- Fallacia della mano calda: significato ed esempi

- Apofenia e pareidolia (illusione pareidolitica): spiegazione, esempi

- Fallacia della brutta china (del piano inclinato): significato, esempi

- Argumentum ad ignorantiam: significato ed esempi

- Argumentum ad judicium (ad populum): significato ed esempi

- Argumentum ab auctoritate (argomento autorevole) significato, esempi

- Argumentum ad hominem e ad personam: contestare l’interlocutore e non le sue idee

- Fallacia del cecchino texano e clustering illusion: significato ed esempi

- Ignoratio elenchi: la manovra diversiva di chi “finge di non capire”

- Reductio ad Hitlerum e legge di Godwin: significato ed esempi

- Effetto carrozzone, groupthink, pensiero di gruppo e saggezza della folla

- Reductio ad absurdum (dimostrazione per assurdo) e argomento fantoccio

- Fallacia dell’ignoranza invincibile e ragionamento circolare (diallele)

- Charles Darwin, effetto Dunning-Kruger e sindrome dell’impostore

- Capro espiatorio: definizione e significato in psicologia e sociologia

- Fallacie logiche nella retorica ed in politica: caratteristiche, tipi esempi

- Il condizionamento meccanico nella vita quotidiana: il “lavaggio del cervello” delle pubblicità

- Sindrome del tramonto o del crepuscolo: cause, sintomi e cura

- Ritardo mentale nei bambini lieve, moderato, grave: si guarisce?

- Sei di destra? Sei meno intelligente, lo dice la scienza

- Sillogismo: spiegazione, tipi, esempi, etimologia

- Gli italiani nati nel sud sono meno intelligenti dei settentrionali?

- Siamo più stupidi dei nostri genitori: il nostro quoziente d’intelligenza è sempre più basso

- Apofenia e pareidolia (illusione pareidolitica): spiegazione, esempi

- Riflesso di Pavlov, ricompensa di Thorndike, gabbia di Skinner: il condizionamento meccanico

- Le 8 tattiche usate dai narcisisti per controllare le conversazioni

- Teoria del cigno nero: significato della metafora in psicologia con esempi

- Associazione, effetto e rinforzo: le leggi del condizionamento

- Apprendimento inconsapevole, assuefazione, messaggi inattesi: le forme di apprendimento

- Effetto Pigmalione in psicologa, nell’insegnamento, nella vita e nell’amore

- Effetto Cocktail Party: discriminare la voce dell’interlocutore e interessarsi se qualcuno dice il nostro nome

- La memoria prodigiosa dei gran maestri di scacchi: come fanno ad averla?

- Creatività in psicologia: definizione, significato, pensiero divergente

- I cervelli del nord sono più grandi di quelli del sud: milanesi più intelligenti dei palermitani?

- La persona più intelligente al mondo mai esistita nella storia dell’uomo

- Il quoziente intellettivo? Un mito da sfatare

- “I neri meno intelligenti dei bianchi: lo dice il DNA”. James Watson rischia ritiro del Nobel

- Sono più intelligenti gli uomini o le donne? Nuovi studi hanno decretato il vincitore

- Ti spiego perché tuo fratello maggiore è più intelligente di te

- Un ingegnere italiano nella classifica dei 20 uomini con il quoziente intellettivo più alto al mondo

- “Sono un profeta che parla con gli animali”: predicatore sbranato dai leoni

- Prega per anni il Signore degli Anelli: “Pensavo fosse S.Antonio”

- Il bello della conoscenza è quello di colmare la nostra mente seminandovi dei dubbi, non riempendola di certezze

- Bertrand Russell: “Perché non sono cristiano”, la sua teiera ed il rasoio

- Sempre preoccupati ed ansiosi? Siete i più intelligenti

- Fai molte battute? Allora sei intelligente!

- I videogiochi ti fanno diventare più intelligente

- I trenta cibi che ringiovaniscono il tuo cervello

- Ritardo mentale nei bambini lieve, moderato, grave: si guarisce?

- La donna deve dormire più dell’uomo: il cervello di lei lavora più di quello di lui

Dott. Emilio Alessio Loiacono

Medico Chirurgo

Direttore dello Staff di Medicina OnLine

Se ti è piaciuto questo articolo e vuoi essere aggiornato sui nostri nuovi post, metti like alla nostra pagina Facebook o unisciti al nostro gruppo Facebook o ancora seguici su Twitter, su Instagram, su Mastodon, su YouTube, su LinkedIn, su Tumblr e su Pinterest, grazie!

Condividi questo articolo:

La sindrome di Gilles de la Tourette (più semplicemente sindrome di Tourette) è un disordine neurologico che esordisce nell’infanzia scomparendo spesso durante l’adolescenza, caratterizzata dalla presenza di tic motori e fonatori incostanti, talvolta fugaci e altre volte cronici, la cui gravità può variare da estremamente lievi a invalidanti.

La sindrome di Gilles de la Tourette (più semplicemente sindrome di Tourette) è un disordine neurologico che esordisce nell’infanzia scomparendo spesso durante l’adolescenza, caratterizzata dalla presenza di tic motori e fonatori incostanti, talvolta fugaci e altre volte cronici, la cui gravità può variare da estremamente lievi a invalidanti.

La sindrome di Gilles de la Tourette (più semplicemente sindrome di Tourette) è un disordine neurologico che esordisce nell’infanzia scomparendo spesso durante l’adolescenza, caratterizzata dalla presenza di tic motori e fonatori incostanti, talvolta fugaci e altre volte cronici, la cui gravità può variare da estremamente lievi a invalidanti. In molti pazienti, seguiti in cliniche specialistiche, emergono alcune comorbilità (diagnosi di patologie co-concorrenti diverse dalla sindrome di Tourette), come la sindrome da deficit di attenzione e iperattività(ADHD) e il disturbo ossessivo compulsivo (DOC). Le altre condizioni sono spesso secondarie a peggioramento nel quadro clinico del paziente e quindi è fondamentale identificarle correttamente e trattarle.[3] La definizione di “sindrome di Tourette” non identifica una specifica malattia o un preciso vulnus neurologico, ma piuttosto un quadro comportamentale caratterizzato da diverse manifestazioni (anche cognitive) che sono presenti anche in altre sindromi: diversi fattori neuro-fisiologici possono portare infatti alle stesse manifestazioni.

La sindrome di Gilles de la Tourette (più semplicemente sindrome di Tourette) è un disordine neurologico che esordisce nell’infanzia scomparendo spesso durante l’adolescenza, caratterizzata dalla presenza di tic motori e fonatori incostanti, talvolta fugaci e altre volte cronici, la cui gravità può variare da estremamente lievi a invalidanti. In molti pazienti, seguiti in cliniche specialistiche, emergono alcune comorbilità (diagnosi di patologie co-concorrenti diverse dalla sindrome di Tourette), come la sindrome da deficit di attenzione e iperattività(ADHD) e il disturbo ossessivo compulsivo (DOC). Le altre condizioni sono spesso secondarie a peggioramento nel quadro clinico del paziente e quindi è fondamentale identificarle correttamente e trattarle.[3] La definizione di “sindrome di Tourette” non identifica una specifica malattia o un preciso vulnus neurologico, ma piuttosto un quadro comportamentale caratterizzato da diverse manifestazioni (anche cognitive) che sono presenti anche in altre sindromi: diversi fattori neuro-fisiologici possono portare infatti alle stesse manifestazioni. Il problem solving (in italiano “il risolvere un problema”) è un’attività del pensiero che un organismo o un dispositivo di intelligenza artificiale mettono in atto per raggiungere una condizione desiderata a partire da una condizione data. Va precisato che il problem solving è solo una parte del processo di risoluzione di un problema: la procedura infatti comprende i processi seguenti: problem finding, problem shaping e problem solving.

Il problem solving (in italiano “il risolvere un problema”) è un’attività del pensiero che un organismo o un dispositivo di intelligenza artificiale mettono in atto per raggiungere una condizione desiderata a partire da una condizione data. Va precisato che il problem solving è solo una parte del processo di risoluzione di un problema: la procedura infatti comprende i processi seguenti: problem finding, problem shaping e problem solving.

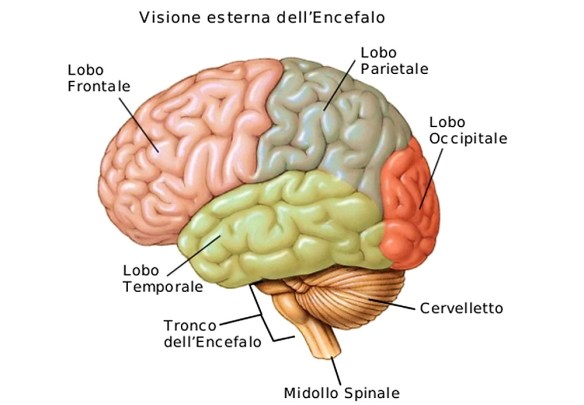

La neocorteccia, detta anche isocorteccia o neopallio o neocortex, rappresenta quella porzione di corteccia cerebrale con sviluppo filogenetico più recente. Nell’uomo essa rappresenta circa il 90% della superficie cerebrale. Composto da neuroni in sinapsi, viene schematicamente diviso in sei strati successivi, dal più superficiale al più interno:

La neocorteccia, detta anche isocorteccia o neopallio o neocortex, rappresenta quella porzione di corteccia cerebrale con sviluppo filogenetico più recente. Nell’uomo essa rappresenta circa il 90% della superficie cerebrale. Composto da neuroni in sinapsi, viene schematicamente diviso in sei strati successivi, dal più superficiale al più interno: Gli attacchi di panico o disturbo da panico, classificati ed inseriti come “panic attack/s (PA/s)” o “panic disorder (PD)” nel DSM (Manuale diagnostico e statistico dei disturbi mentali), sono una classe di disturbi d’ansia, a loro volta i più comuni disturbi psichiatrici, che costituiscono un fenomeno sintomatologico complesso e piuttosto diffuso (si calcola che 10 milioni di italiani abbiano subito uno o più attacchi di panico). Il disturbo di solito esordisce nella tarda adolescenza o nella prima età adulta ed ha un’incidenza da due a tre volte maggiore nelle donne rispetto agli uomini. Tuttavia, spesso tale disturbo non viene riconosciuto e di conseguenza non viene mai curato. La maggior parte delle persone guarisce, mentre una rilevante minoranza sviluppa invece un disturbo da recidiva di attacchi di panico.

Gli attacchi di panico o disturbo da panico, classificati ed inseriti come “panic attack/s (PA/s)” o “panic disorder (PD)” nel DSM (Manuale diagnostico e statistico dei disturbi mentali), sono una classe di disturbi d’ansia, a loro volta i più comuni disturbi psichiatrici, che costituiscono un fenomeno sintomatologico complesso e piuttosto diffuso (si calcola che 10 milioni di italiani abbiano subito uno o più attacchi di panico). Il disturbo di solito esordisce nella tarda adolescenza o nella prima età adulta ed ha un’incidenza da due a tre volte maggiore nelle donne rispetto agli uomini. Tuttavia, spesso tale disturbo non viene riconosciuto e di conseguenza non viene mai curato. La maggior parte delle persone guarisce, mentre una rilevante minoranza sviluppa invece un disturbo da recidiva di attacchi di panico.

L’area di Broca (in inglese “Broca’s area”; pronuncia: brocà) è una parte dell’emisfero dominante del cervello (spesso il sinistro) ed ha funzioni relative all’elaborazione del linguaggio. L’area di Wernicke (in inglese “Wernicke’s area”) è una parte del lobo temporale del cervello le cui funzioni sono coinvolte nella comprensione del linguaggio.

L’area di Broca (in inglese “Broca’s area”; pronuncia: brocà) è una parte dell’emisfero dominante del cervello (spesso il sinistro) ed ha funzioni relative all’elaborazione del linguaggio. L’area di Wernicke (in inglese “Wernicke’s area”) è una parte del lobo temporale del cervello le cui funzioni sono coinvolte nella comprensione del linguaggio. La psicoterapia ad indirizzo funzionale si sviluppa negli anni ’80 con le ricerche di Luciano Rispoli, fondatore della Scuola di Napoli, e si sviluppa con presupposti diversi dal primo funzionalismo.

La psicoterapia ad indirizzo funzionale si sviluppa negli anni ’80 con le ricerche di Luciano Rispoli, fondatore della Scuola di Napoli, e si sviluppa con presupposti diversi dal primo funzionalismo.